DeepSeek本地部署超级详细教程 - 人工智能 AI

最近,想必大家都被DeepSeek刷屏了,作为一款现象级的AI产品,以其先进的算法、卓越的能力、亲民的价格和开源性,凭一己之力推动了国内AI大模型的跨越式发展。DeepSeek在今年1月28日的日活跃数首次超越豆包,众多云服务提供商(阿里云、腾讯云、百度智能云等)纷纷宣布支持DeepSeek模型的一键部署,芯片制造商业完成了于DeepSeek的适配。在这种情况下又遭受了来自国外的网络攻击,导致用户使用时经常出现服务器繁忙现象,将DeepSeek部署在本地电脑上就方便很多了,还能降低对网络的依赖。

将DeepSeek部署在本地,只需三步即可完成,超级简单。

第一步、安装运行框架 - Ollama

Ollama是一个开源的大型语言模型服务工具,用于简化在本地运行大语言模型的过程,帮助用户快速在本地运行、管理和部署大型语言模型。

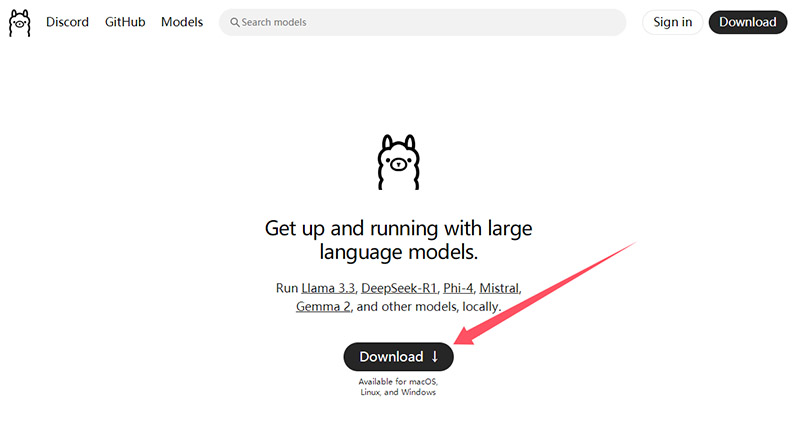

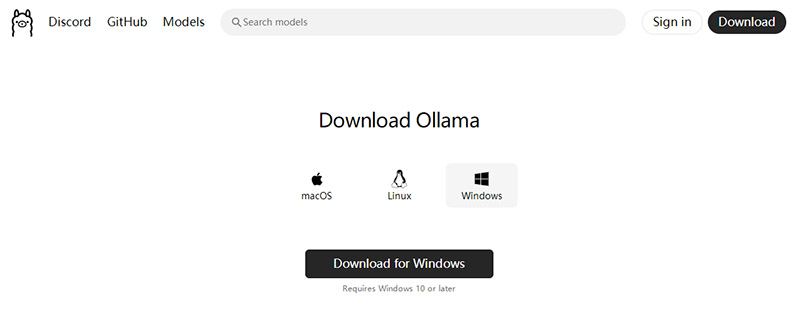

1、官网下载Ollama

下载地址:https://ollama.com/,打开连接如下图所示

点击Download按钮,进入下载页面,如图所示,三个系统都可以选择,小编用的是Windows。点击下载按钮,下载速度较慢,预计需要30分钟。

2、睿鑫气模服务器下载Ollama

如果官网下载速度实在太慢,也可以选择从睿鑫气模服务器上下载:下载Ollama安装包,这是小编在2025年2月12日从Ollama官网下载保存的。

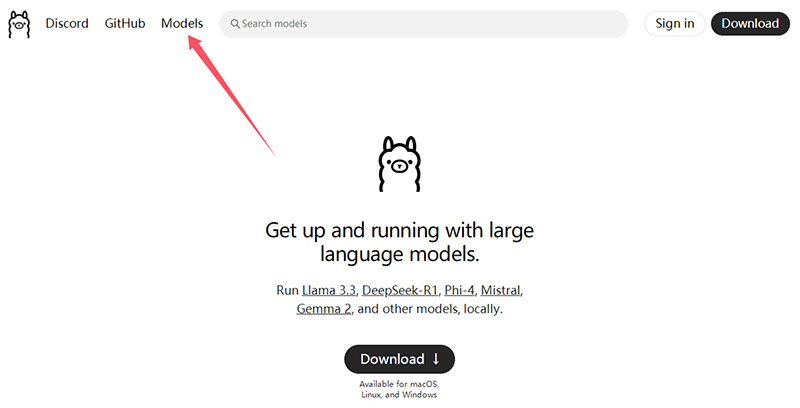

第二步:下载DeepSeek-R1

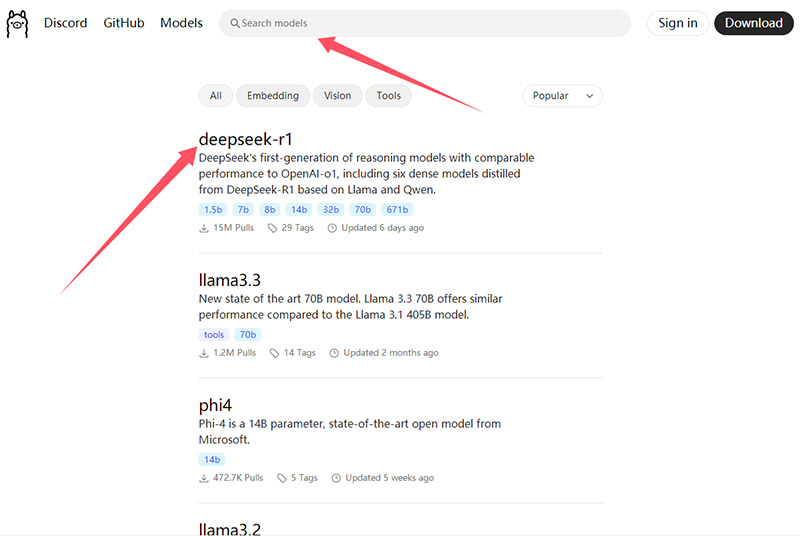

还是Ollama官网,顶部导航点击Models进入模型列表页面,如下图

进入就可以看到deepSeek-r1模型信息,如果找不到也可以在搜索框搜索,如下图

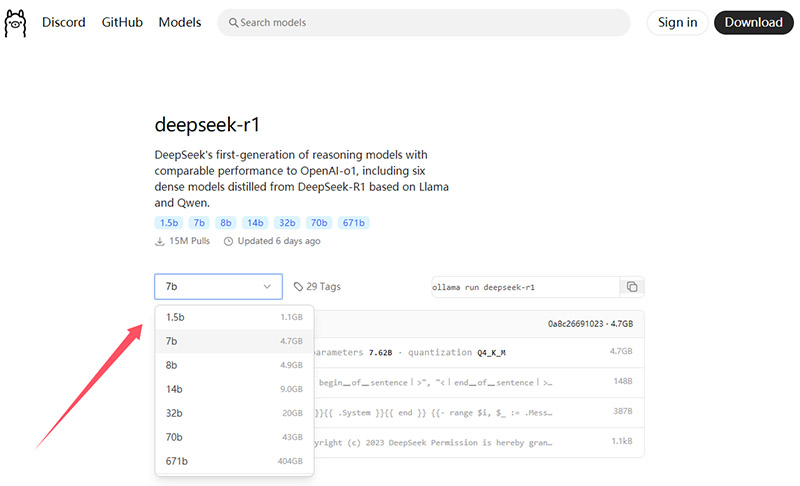

点击进入,选择自己需要的模型来下载,如下图

DeepSeek-R1模型版本越高,对电脑配置要求越高,主要体现在CPU、内存、显卡这三方面。小编将每一个版本对应的电脑配置要求列成了一个表,希望能帮到你,如下表

| 模型版本 | CPU要求 | 内存要求 | 显卡要求 | 硬盘大小 | 下载代码 |

|---|---|---|---|---|---|

| 1.5b-1.1GB | 4核以上 | 8GB RAM | NVIDIA GTX 1650或同级别 | 50GB空闲空间 | ollama run deepseek-r1:1.5b |

| 7b-4.7GB | 6核以上 | 16GB RAM | 4GB显存 | 100GB空闲空间 | ollama run deepseek-r1:7b |

| 8b-4.9GB | 8核以上 | 16GB RAM | 6GB显存 | 120GB空闲空间 | ollama run deepseek-r1:8b |

| 14b-9GB | 12核多线程 | 32GB | 16GB显存 | 200GB空闲空间 | ollama run deepseek-r1:14b |

| 32b-20GB | 高性能处理器 | 64GB | 32GB显存 | 500GB空闲空间 | ollama run deepseek-r1:32b |

| 70b-43GB | ... | ... | ... | ... | ollama run deepseek-r1:70b |

| 671b-404GB | ... | ... | ... | ... | ollama run deepseek-r1:671b |

70b和671b是非常专业的高性能版本,这里不做解释

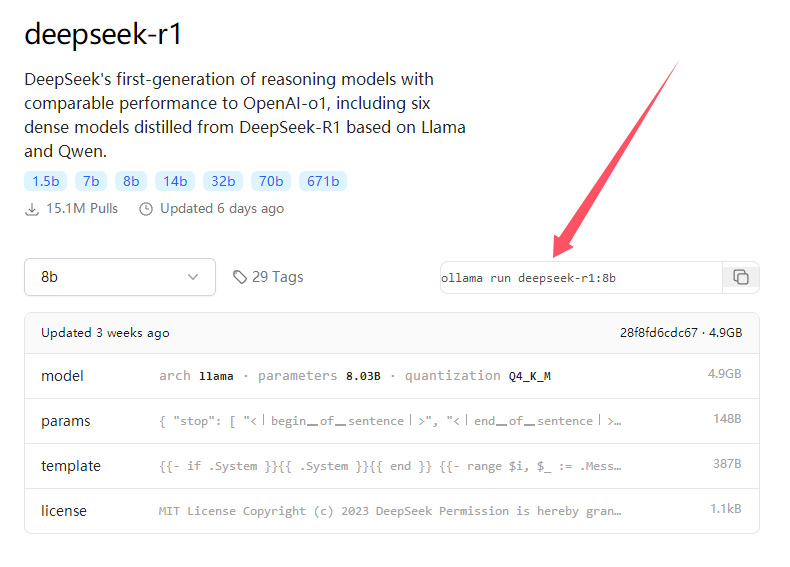

复制自己需要版本的下载代码,如下图

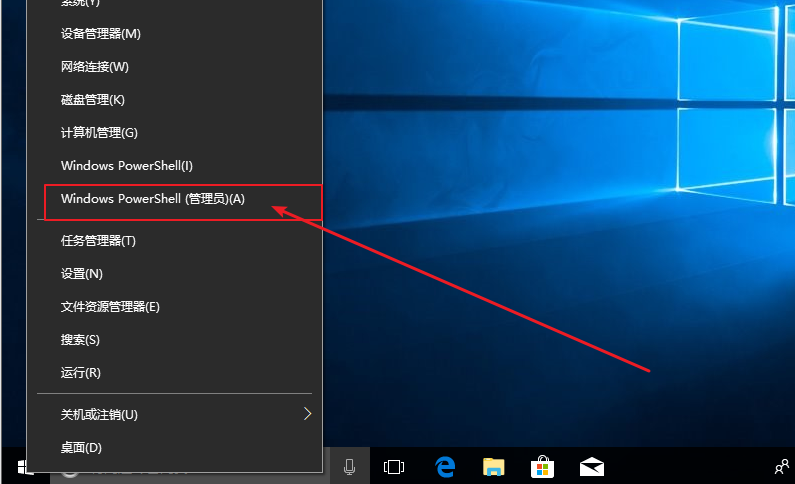

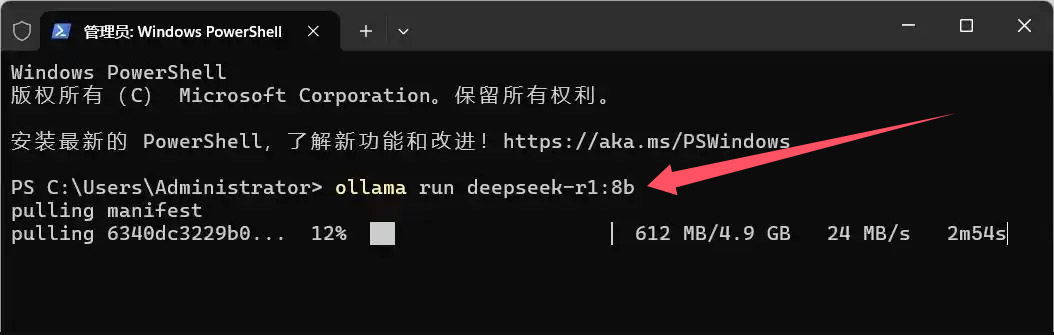

在本地电脑左下角的Windows【开始菜单】上单击鼠标右键,然后左键单击【Windows powerShell (管理员)(A)】或【终端管理员】。

将复制好的下载代码粘贴到Windows powerShell (管理员)运行框,敲回车开始自动下载安装,如下图

等待下载完成,并自动安装,出现success即代表下载并安装完成,如下图

此时即可在Windows powerShell (管理员)运行框中进行对话,不过,这样的对话框实在不忍直视。

第三部、前端对话框搭建

前端对话框的搭建,我们可以借助Chatbox客户端实现,最终的界面友好、美观,操作简单。

Chatbox官网地址:https://chatboxai.app/zh,直接点击下载,完成安装。

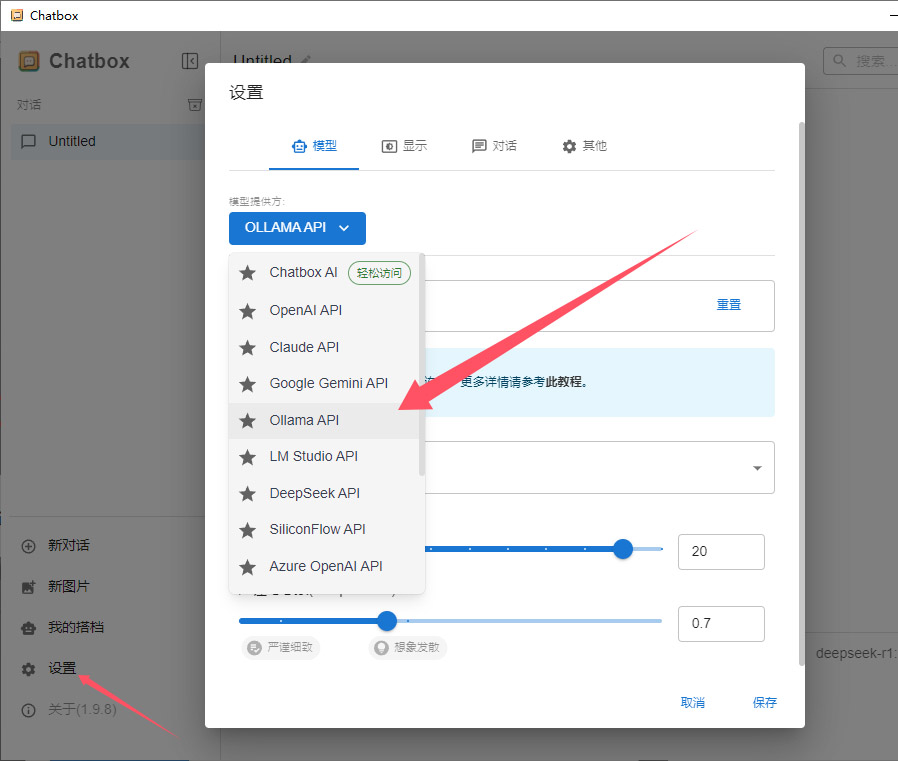

安装完成后需要进行简单的配置,单击设置

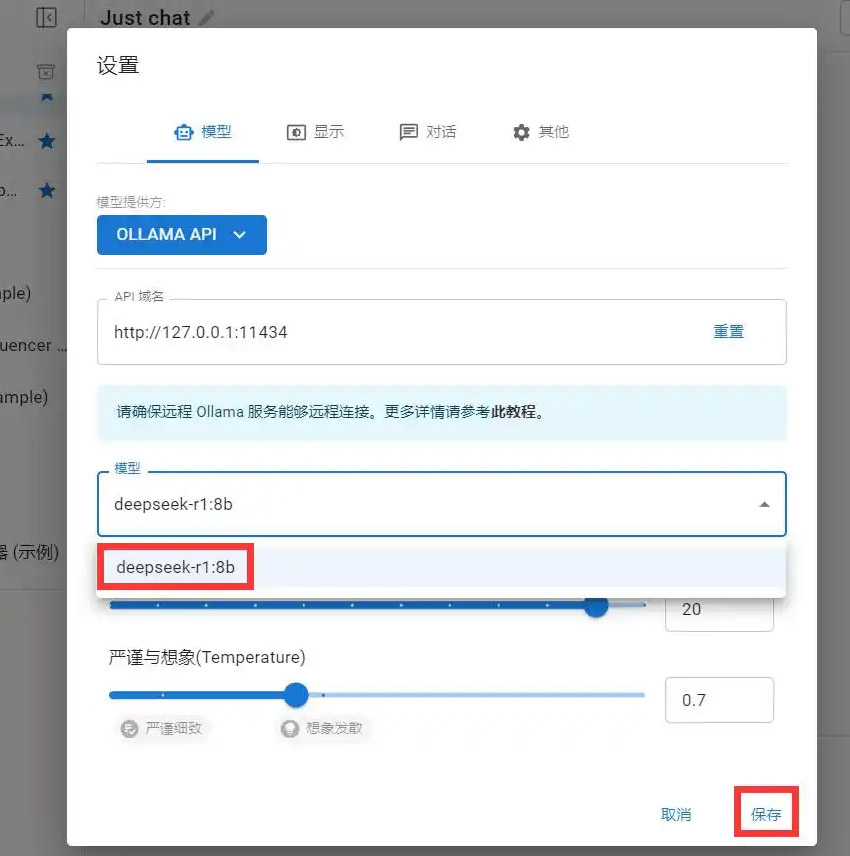

依次选择【Ollama API】;API域名自动不用管;模型选择你刚刚安装的【deepSeek-r1: **】;下面的消息数量和想象自动即可,最后点击保存。

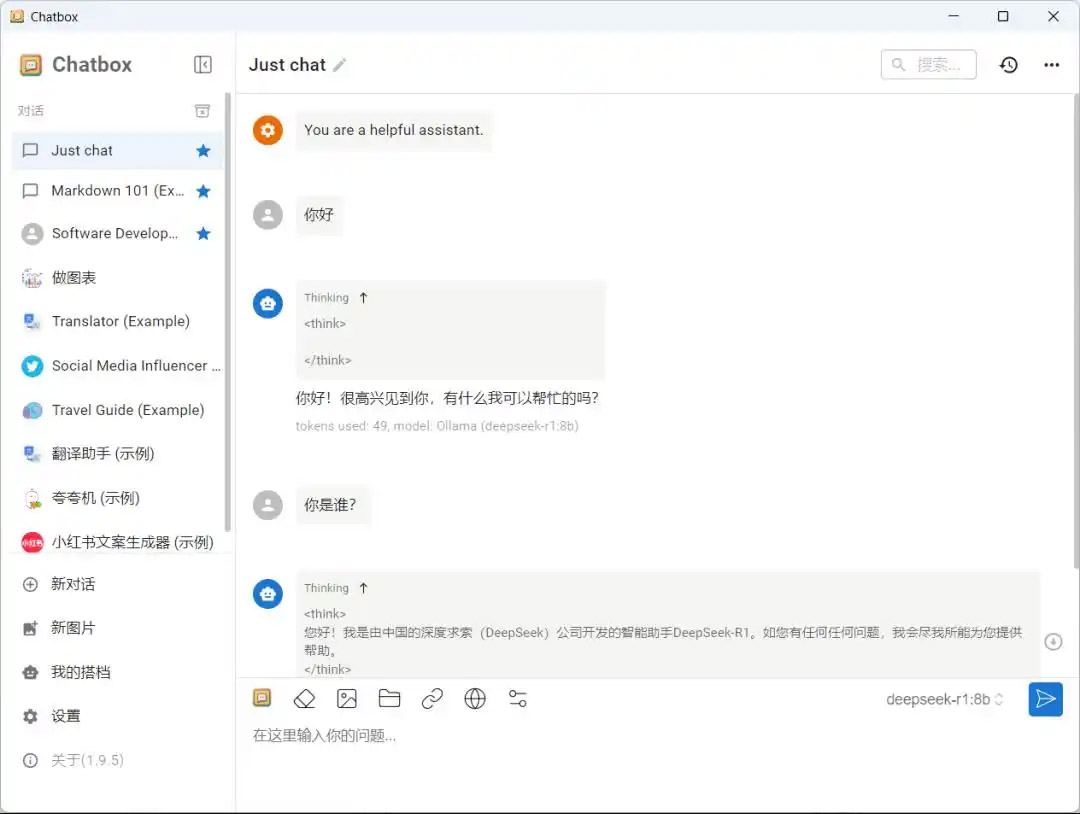

到这里就部署完成了,可以开始你的AI对话之旅了。

通过以上三步,DeepSeek就部署在本地电脑上了,有些不方便公开的数据,比如实验数据,可以通过部署大模型到本地的方式进行处理,不用担心数据泄露。

以上是睿鑫气模整理的关于DeepSeek AI模型部署在本地电脑上的操作方法,希望能够帮到你。